在当今数据驱动的商业环境中,数据架构是企业构建高效数据处理能力的核心。一个清晰、灵活的数据架构能够确保数据在不同系统间顺畅流动,为后续分析和决策提供坚实基础。

高效的Pipeline设计是实现数据价值的关键环节。通过自动化流程,Pipeline能够将原始数据转化为可操作的信息,减少人工干预,提升数据处理的速度与准确性。

数据架构与Pipeline相辅相成,前者定义了数据的结构和流向,后者则负责数据的实际流转与处理。两者的结合使企业能够快速响应市场变化,优化业务流程。

在实际应用中,企业需要根据自身需求选择合适的技术栈和工具,例如使用Apache Kafka进行实时数据流处理,或利用Spark进行大规模数据计算。这些技术的选择直接影响Pipeline的效率与稳定性。

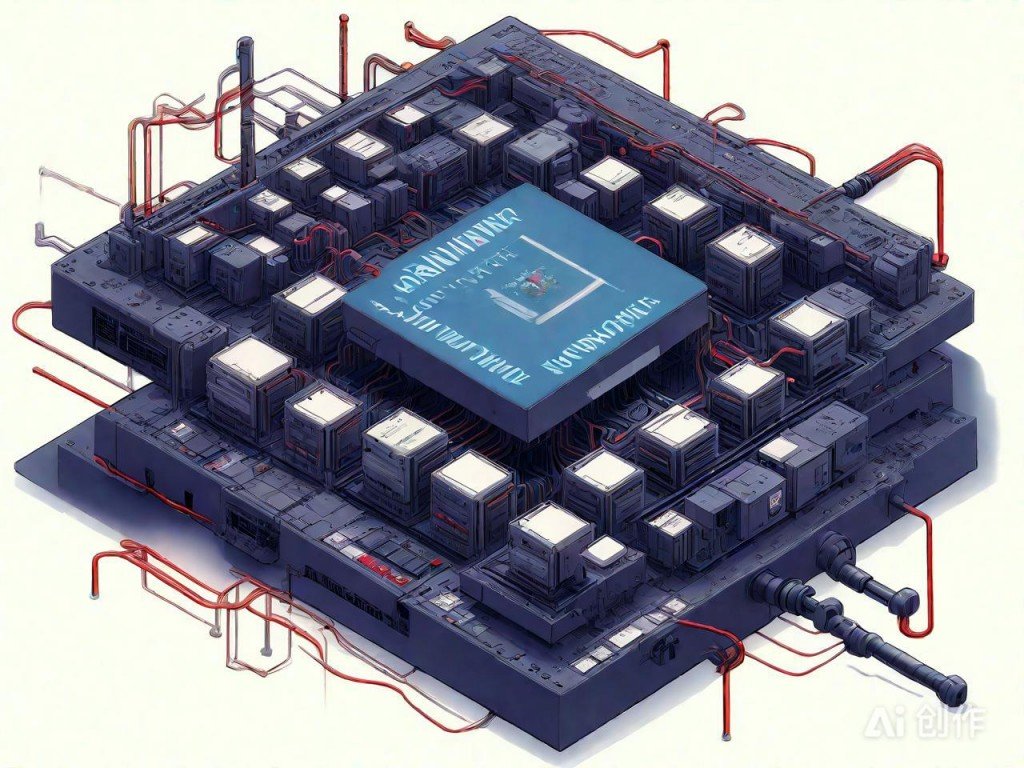

AI绘图结果,仅供参考

未来,随着数据量的持续增长,数据架构和Pipeline的重要性将进一步凸显。企业应不断优化其数据基础设施,以支撑更复杂的数据分析和智能化应用。