Linux大数据集群的构建需要从基础环境准备开始。安装合适的Linux发行版,如Ubuntu或CentOS,并确保系统更新到最新版本。配置网络和主机名是关键步骤,以便后续节点之间的通信。

安装Java环境是运行大数据工具的前提。选择适合的JDK版本,例如OpenJDK 8或11,并设置JAVA_HOME环境变量。验证Java安装是否成功,可以通过命令行输入java -version。

下一步是安装Hadoop或Spark等大数据框架。下载对应版本的压缩包,解压后配置核心文件如core-site.xml、hdfs-site.xml和yarn-site.xml。根据集群规模调整参数,如副本数和内存分配。

启动Hadoop集群前,需格式化NameNode。使用hdfs namenode -format命令完成初始化。随后启动HDFS和YARN服务,检查各节点状态是否正常运行。

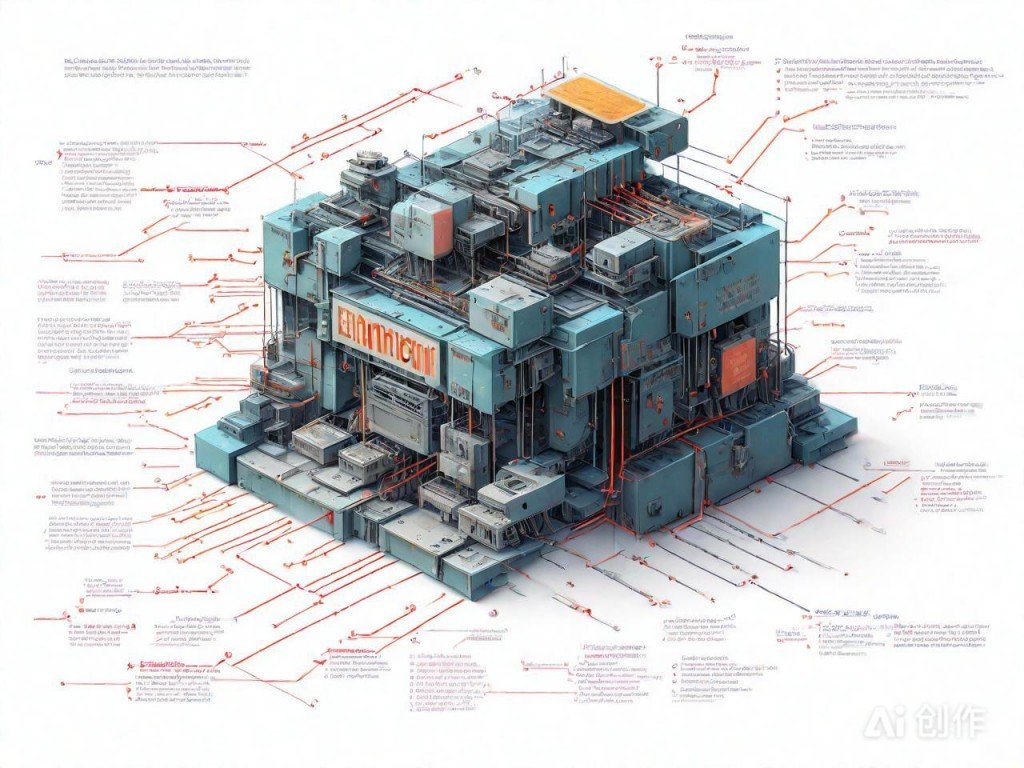

AI绘图结果,仅供参考

配置SSH免密登录可提升操作效率。生成密钥对并复制到所有节点,确保无密码访问。测试连接是否成功,避免后续操作中出现权限问题。

•通过简单任务测试集群功能。例如运行WordCount示例,观察任务执行情况和日志输出。确保数据能正确读取、处理并存储,标志着集群搭建完成。